Dans le domaine du technique SEO, les logs serveurs constituent une source de vérité brute sur le comportement des crawlers. Contrairement aux outils de Search Console ou de web analytics qui affichent des données post-traitées, les fichiers de logs HTTP enregistrent chaque hit reçu par le serveur. Leur analyse permet d’identifier précisément quelles pages sont réellement visitées par les robots, à quelle fréquence, avec quels statuts de réponse, et avec quel impact sur la bande passante ou la latence serveur. Cet article propose une méthode rigoureuse et unifiée pour extraire, parser, enrichir et exploiter ces logs dans une optique SEO.

1. Typologie des logs et prérequis serveur

Les logs HTTP sont générés au niveau du serveur web (Apache, Nginx, IIS…) et doivent être activés avec un format enrichi, de préférence combined log format ou customisé pour inclure:

- IP source

- Date/heure complète (avec fuseau UTC)

- Méthode HTTP

- Chemin complet de l’URL (avec paramètres GET)

- Code HTTP retourné (200, 301, 404…)

- User-Agent

- Referer (important pour les bots qui suivent des liens internes)

- Durée de traitement (optionnelle, utile pour corréler performance serveur)

Exemple de ligne complète:

66.249.66.1 - - [28/Apr/2025:06:25:14 +0000] "GET /produits?id=456 HTTP/1.1" 200 "https://site.com" "Googlebot/2.1 (+http://www.google.com/bot.html)"

2. Extraction et stockage des logs

Sur des sites à fort trafic, les logs peuvent représenter plusieurs Go par jour. Il est essentiel de mettre en place une stratégie:

- Rotation (logrotate): journalière avec compression Gzip

- Centralisation: export vers un serveur distant (rsync, scp, syslog, ou S3 bucket)

- Durée de rétention: 90 à 180 jours pour permettre les analyses longitudinales

- Sécurisation: accès restreint en lecture seule, anonymisation des IP si RGPD

Pour les environnements containerisés, les logs doivent être redirigés en sortie standard et agrégés par un agent (Fluentd, Logstash, Filebeat).

3. Parsing et nettoyage des données

L’analyse SEO nécessite une réduction du bruit:

- Filtrage des bots légitimes: Googlebot, Bingbot, Applebot, YandexBot (validation DNS reverse et User-Agent)

- Exclusion du trafic humain: navigateur, HEAD, OPTIONS, requêtes Ajax

- Suppression des ressources statiques: *.js, *.css, *.png, *.svg

- Normalisation des URLs: suppression des utm_*, sessionid, tri, pagination

- Détection d’anomalies: spikes d’erreurs 5xx, URLs inconnues, pics de crawl

Les logs sont ensuite stockés dans une base exploitable (Elasticsearch, BigQuery, SQLite, ou CSV pour petit volume) pour exploitation croisée.

4. Croisement avec les données SEO

Les logs seuls ne suffisent pas. Il faut les enrichir avec:

- Sitemap XML: pour identifier les URLs non crawled malgré leur soumission

- Google Search Console: pour croiser avec l’état d’indexation (via l’API ou Data Studio)

- Analytics (GA4, Matomo): pour repérer les pages à forte performance non crawled

- Statuts HTTP internes: pour vérifier les redirections permanentes ou temporaires

Objectif: repérer les « orphan pages » (performantes mais jamais crawlées) et les « pages zombies » (crawled trop souvent mais sans valeur SEO).

5. Indicateurs clés à suivre

- Crawl ratio: pages stratégiques / pages réellement visitées

- Coverage du sitemap: % des URLs soumises réellement visitées

- Erreurs 4xx/5xx: nombre de hits par jour, par bot, par répertoire

- Latence moyenne par bot: utile pour détecter les ralentissements spécifiques au crawl

- Crawl depth: profondeur des URLs visitées par les bots (niveau de clics requis)

- Overcrawl des filtres: % de crawl sur des pages filtrées ou avec paramètres inutiles

6. Outils de traitement recommandés

En fonction de la taille de votre projet:

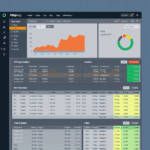

- Screaming Frog Log File Analyzer: léger, idéal pour audits ponctuels

- OnCrawl / Botify: solutions SaaS intégrant machine learning, scoring de priorité de crawl

- ELK Stack (Elastic + Logstash + Kibana): open source, personnalisable, adapté aux architectures DevOps

- BigQuery (Google Cloud): puissant pour l’analyse croisée avec GSC/GA4, requêtes SQL multi-source

- Python + pandas + matplotlib: pour les analyses sur mesure (analyse temporelle, clustering, détection de pics)

7. Actions correctives SEO issues de l’analyse

- Réorganisation du maillage interne: pour remonter les pages non vues par Googlebot

- Blocage ciblé via robots.txt: des filtres, paramètres, facettes inutiles

- Réduction du duplicate crawl: réécriture d’URLs, canonicalisation stricte

- Réduction du temps de réponse serveur: pour éviter que Google réduise la fréquence de crawl

- Création d’un sitemap dynamique: à jour avec les pages réellement utiles

Conclusion – Le log comme fondation du SEO technique avancé

À l’ère des budgets crawl limités, de l’indexation différée et des architectures complexes, l’analyse de logs serveurs devient un instrument décisif pour garantir la visibilité organique. Bien plus qu’un outil de monitoring, il permet une stratégie d’optimisation pilotée par les données, au plus proche du moteur. Pour les sites à fort volume ou les environnements multi-domaines, ce levier devient vital. L’implémentation d’une stack dédiée à l’analyse des logs doit désormais faire partie de toute roadmap SEO technique sérieuse.